鱼羊 发自 凹非寺范冰冰 女同

量子位 | 公众号 QbitAI

在多模态范畴,开源模子也超闭源了!

就在刚刚罢了的Meta开拓者大会上,Llama 3.2闪亮登场:

这回不仅具备了多模态才调,还和Arm等联手,推出了有益为高通和联发科硬件优化的“迁徙”版块。

具体来说,这次Meta一共发布了Llama 3.2的4个型号:

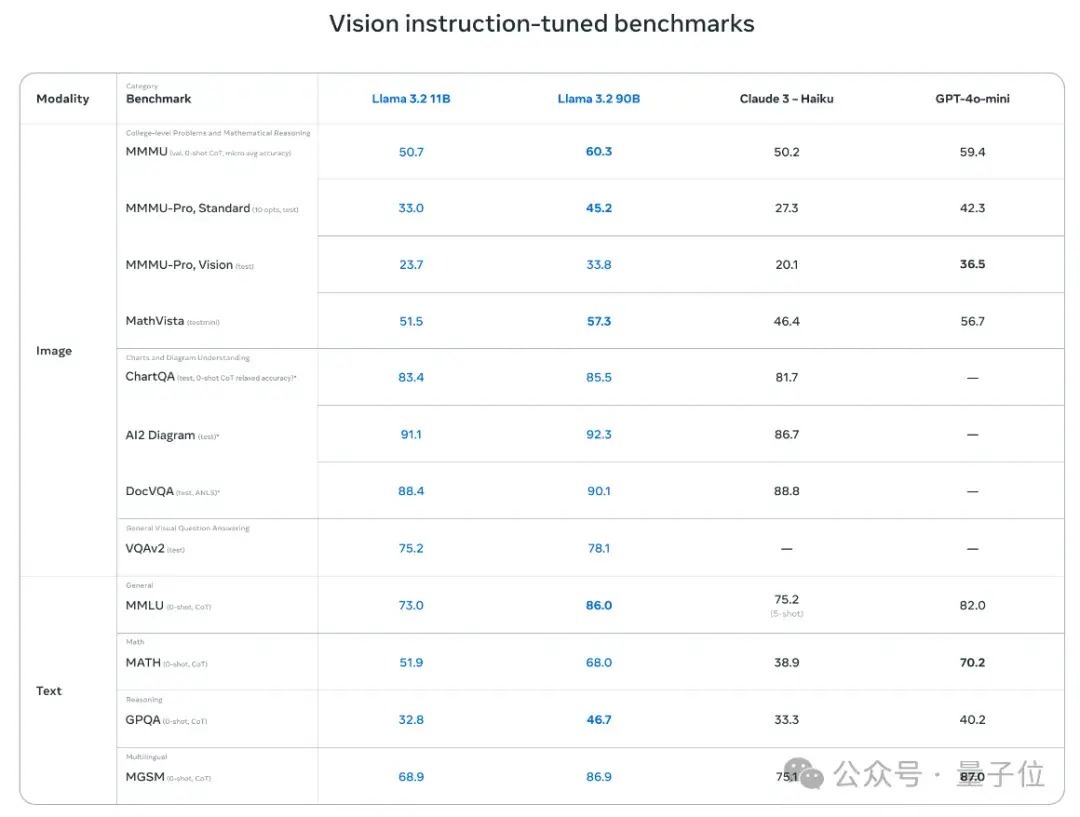

110亿和900亿参数的多模态版块10亿参数和30亿参数的轻量级纯文本模子官方数据显露,与同等范畴的“中微型”大模子比拟,Llama 3.2 11B和90B推崇出了越过闭源模子的性能。

尤其是在图像意会雇务方面,Llama 3.2 11B跳动了Claude 3 Haiku,而90B版块更是能跟GPT-4o-mini掰掰手腕了。

而专为端侧打造的3B版块,在性能测试中推崇也优于谷歌的Gemma 2 2.6B和微软的Phi 3.5-mini。

如斯推崇,真的招引了不少网友的顾惜。

有东说念主茂盛地以为,Llama 3.2的推出可能再次“更正游戏划定”:

端侧AI正在变得越来越要紧。

Meta AI官方对此恢复说念:

其中一些模子参数目很小,但这个技巧真谛真谛紧要。

首个视觉

有计划Llama 3.2具体能作念什么范冰冰 女同,这次官方也释出了不少demo。

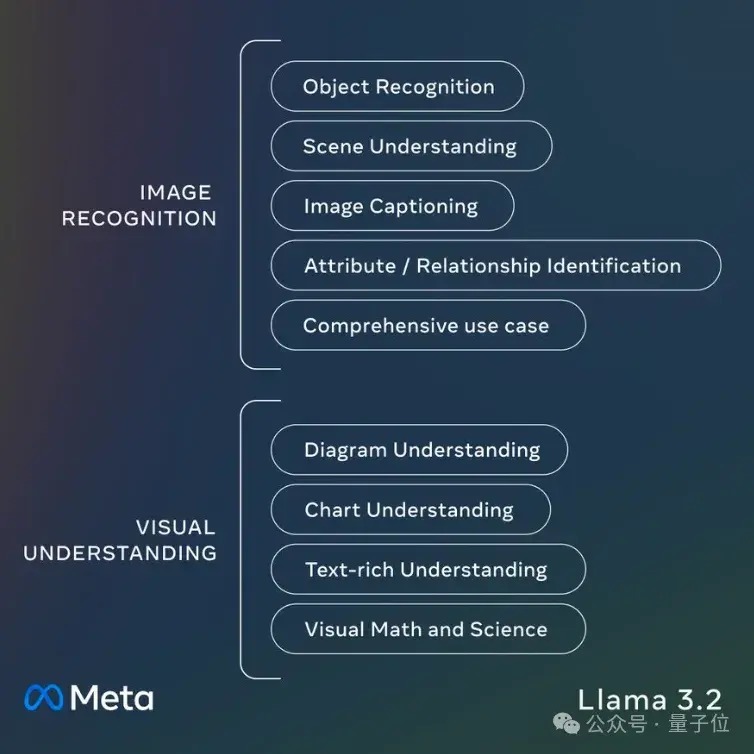

先看个汇总:Llama 3.2 11B和90B相沿一系列多模态视觉任务,包括为图像添加字幕、把柄当然讲话提醒完成数据可视化等等。

草榴社区邀请码,

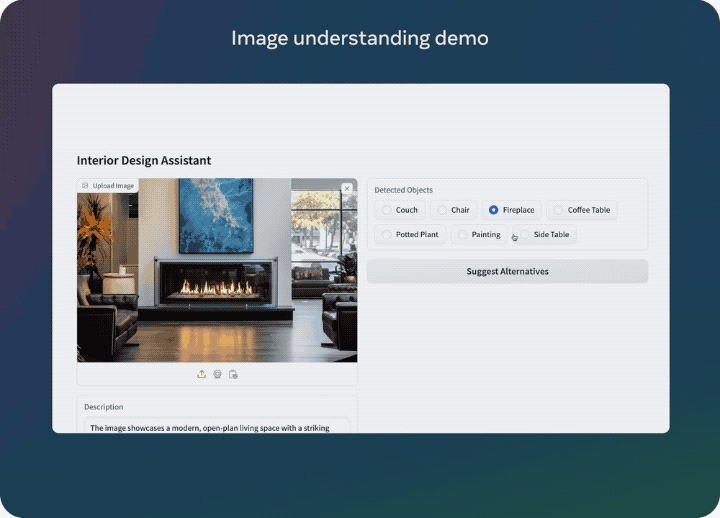

举个,五月天情色丢给Llama 3.2一张图片,它能把图片中的元素逐一拆解,告诉你注意的图片信息:

相通,也不错反过来把柄笔墨提醒找出顺应用户需求的图片。

Llama 3.2 11B和90B亦然首批相沿多模态任务的Llama系列模子,为此,Meta的商议东说念主员打造了一个新的模子架构。

在Llama 3.1的基础之上,商议东说念主员在不更新讲话模子参数的情况下考研了一组适配器权重,将预考研的图像编码器集成到了预考研的讲话模子中。

这么,Llama 3.2既能保捏纯文本功能的完整性,也能get视觉才调。

考研经过中,Llama 3.2经受图像-文本对数据进行考研。考研分为多个阶段,包括在大范畴有噪声数据上的预考研,和更进一步在中等范畴高质地范畴内和学问增强数据上的考研。

在后考研(post-training)中,商议东说念主员通过监督微调(SFT)、停止采样(RS)和径直偏好优化(DPO)进行了几轮对皆。

专为端侧打造的“小”模子至于1B和3B这两个轻量级模子,规画愈加了了:

跟着苹果Apple Intelligence的推出,关于电子消耗市集而言,手机等结尾上的生成式AI照旧成为标配。

而脱离云表独处动手在结尾上的模子,不管是从功能照旧从安全的角度,都是结尾AIGC落地的关键。

△端侧写稿助手Llama 3.2 1B和3B模子由Llama 3.1的8B和70B模子剪枝、蒸馏得回。

不错浅陋意会为,这俩“小”模子是Llama 3.1教出来的“学生”。

Llama 3.2 1B和3B仅相沿文本任务,高下文长度为128K。来自Meta相助方Arm的客户业务线总司理Chris Bergey以为:

来岁头致使本年年底,开拓东说念主员就会在诈骗次序中落地这两个型号的Llama 3.2。

它们领有更好的限定,能在1W功率下或在8毫秒以内提供谜底。

不少网友也为此点赞:

Llama 3.2的轻量级模子能确切更正AI在手机和其他开拓上的诈骗。

还有网友照旧第一技巧践诺上了:

我咋舌于这个1B模子的才调。

这位网友用Llama 3.2 1B动手了一个完整的代码库,并条款它讲究代码,限定是酱婶的:

“不无缺,但远超预期。”

前有OpenAI「Her」全量绽放、谷歌Gemini 1.5迎来紧要升级,Llama这边也紧锣密饱读跟上新手脚,AI圈的这一周,依旧是开源闭源情谊碰撞,充满话题度的一周。

那么,你怎么看Llama这波新发布?

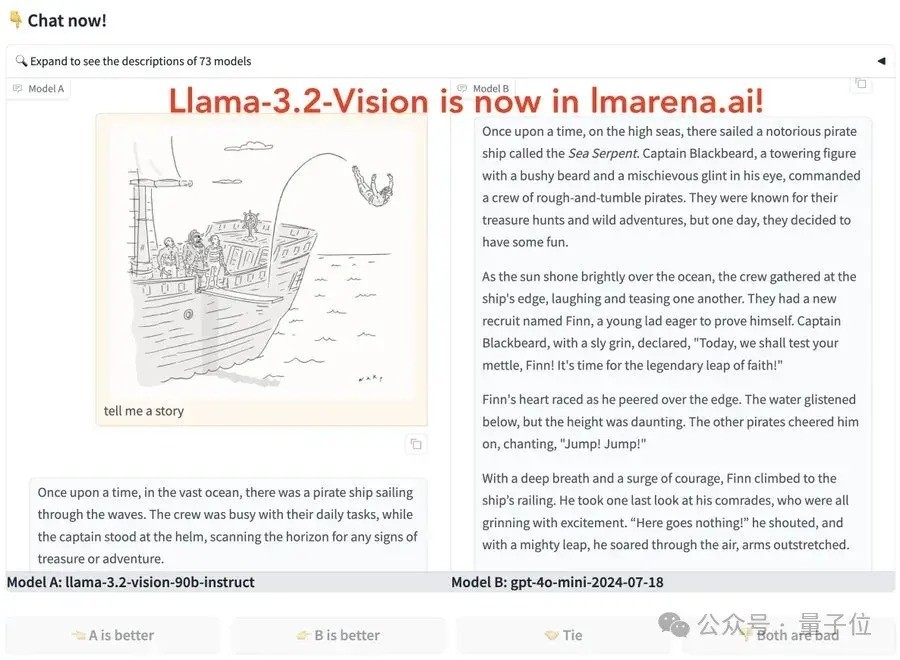

对了,若是你对Llama 3.2感酷好酷好,大模子竞技场照旧不错试玩了。

Ollama、Groq等也已第一技巧更新相沿。

参考齐集:

[1]https://ai.meta.com/blog/llama-3-2-connect-2024-vision-edge-mobile-devices/[2]https://www.cnet.com/tech/mobile/meta-and-arm-want-to-bring-more-ai-to-phones-and-beyond/#google_vignette[3]https://news.ycombinator.com/item?id=41649763